Reverse-o1原理逆向工程图解:深入解析OpenAI o1技术

一、问题定义

OpenAI o1作为一款融合强化学习(RL)与大型语言模型(LLM)的创新产品,其技术原理复杂且独特。本文旨在通过逆向工程图解的方式,深入剖析o1的工作原理,为开发者和技术爱好者提供清晰的技术解析与实施指南。

二、o1技术原理概览

2.1 强化学习与LLM的融合

o1的核心在于将强化学习与大型语言模型相结合,通过生成Hidden COT(Chain of Thought)来增强逻辑推理能力。这一过程不仅提高了模型的准确性,还赋予了模型自我反思与错误修正的能力。

2.2 自我反思与错误修正

与传统的LLM相比,o1在生成答案的过程中能够意识到之前的错误,并进行自动修正。这种能力对于长链条思考及解决复杂任务至关重要,极大提升了LLM的实用性。

三、逆向工程图解o1技术原理

3.1 强化学习机制分析

3.1.1 树搜索结构的应用

o1可能采用了类似AlphaGo的MCTS(蒙特卡洛树搜索)或简单树结构拓展(如Best-of-N Sampling)等策略。这些树搜索结构使得o1能够在复杂的逻辑推理任务中找到最优解。 实施步骤:

- 分析o1的输出,识别其是否采用了树搜索结构。

- 通过对比实验,验证不同树搜索策略对o1性能的影响。 优缺点分析:

- 优点:提高了模型的逻辑推理能力和准确性。

- 缺点:增加了模型的复杂性和计算成本。

3.1.2 新型的RL Scaling law

o1通过控制搜索空间大小(如搜索的宽度和深度)来提升模型能力,这种可扩展性极好的方法被称为新型的RL Scaling law。 实施步骤:

- 调整o1的参数配置,观察其对模型性能的影响。

- 通过实验验证不同参数配置下的模型表现,找到最优配置。 优缺点分析:

- 优点:灵活可扩展,易于通过增加算力提升效果。

- 缺点:参数配置复杂,需要丰富的实验经验。

3.2 LLM与RL的融合机制

3.2.1 Hidden COT的生成

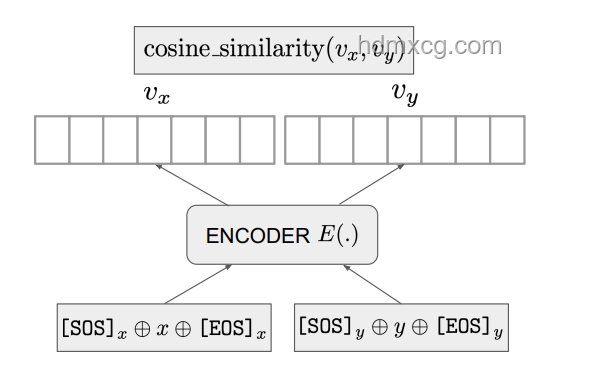

o1通过融合LLM与RL来生成Hidden COT,这一过程是o1技术原理的关键所在。Hidden COT不仅展示了模型的推理过程,还提高了答案的准确性。 实施步骤:

- 分析o1生成的Hidden COT,理解其推理过程。

- 尝试在自定义任务中生成Hidden COT,验证o1的推理能力。 优缺点分析:

- 优点:提高了模型的透明度和可解释性。

- 缺点:增加了模型的计算负担和输出长度。

3.2.2 语言、世界知识与逻辑推理的解耦

o1通过解耦语言、世界知识与逻辑推理三个能力,使得小模型也能具备强大的逻辑推理能力。这一方法为小模型的技术发展提供了新的思路。 实施步骤:

- 采用“能力分治”(DCA)模式,将语言、世界知识与逻辑推理能力分开训练。

- 结合o1的技术原理,优化小模型的逻辑推理能力。 优缺点分析:

- 优点:降低了小模型的技术门槛,提高了其实用性。

- 缺点:需要额外的训练和优化步骤,增加了开发成本。

四、预防建议与后续措施

4.1 预防建议

- 在应用o1技术时,应充分考虑模型的计算成本和资源需求,避免过度消耗资源。

- 在训练和优化模型时,应注重数据的多样性和质量,以提高模型的泛化能力。

4.2 后续措施

- 持续关注OpenAI o1的技术更新和社区反馈,不断优化和改进自己的模型。

- 探索将o1技术应用于更多领域和场景,如自然语言处理、智能问答、推荐系统等。

五、常见问答(Q&A)

Q1:o1是如何实现自我反思与错误修正的? A1:o1通过融合强化学习与大型语言模型,生成Hidden COT来展示推理过程。在推理过程中,o1能够识别并修正之前的错误,从而实现自我反思与错误修正。 Q2:o1的强化学习机制有哪些特点? A2:o1的强化学习机制可能采用了树搜索结构(如MCTS或Best-of-N Sampling)和新型的RL Scaling law。这些特点使得o1能够在复杂的逻辑推理任务中找到最优解,并通过调整参数配置来提升模型性能。 Q3:如何将o1的技术原理应用于小模型? A3:可以采用“能力分治”(DCA)模式,将语言、世界知识与逻辑推理能力分开训练。结合o1的技术原理,优化小模型的逻辑推理能力,使其具备更强的实用性。 通过以上逆向工程图解与分析,我们对OpenAI o1的技术原理有了更深入的理解。希望本文能为开发者和技术爱好者提供有价值的参考与指导。

访客评论 (1 条)

发表您的看法: